*Por Gaston Giribet

“Cuando (...) sobre un ambiente de sombra se proyecta una sombra más espesa... ¿qué le acontece a la poesía?", se preguntaba Macedonio Fernández en sus Cuadernos de todo y nada. Podríamos preguntarnos lo mismo nosotros acerca de la ciencia. Hoy, 12 de mayo de 2022, la colaboración Event Horizon Telescope, en conferencias de prensa simultáneas alrededor del mundo, dio a conocer la primera fotografía del agujero negro supermasivo que se encuentra en el centro de nuestra galaxia. La astrónoma Feryal Özel, quien estuvo a cargo del anuncio en la conferencia de la National Science Foundation (NSF), se refirió a Sagittarius A* como un “gigante gentil”, acaso en referencia su actividad famélica.

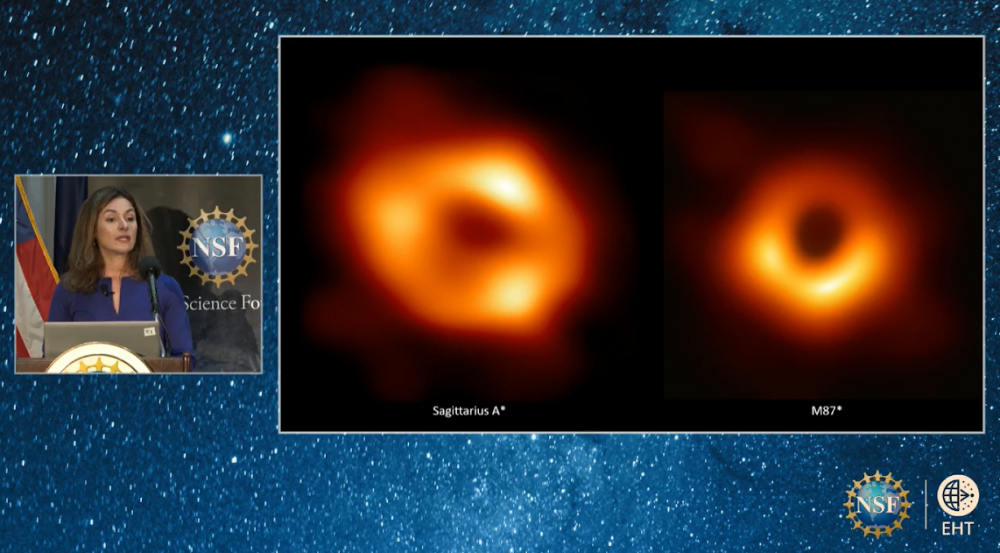

A la izquierda, la imagen de Sagittarius A* (el agujero negro supermasivo, de 4.000.000 masas solares, ubicado en el centro de nuestra galaxia, a 26.000 años luz de aquí). A la derecha, la imagen de M87* publicada en 2019 (el agujero negro supermasivo, de 6.600.000.000 masas solares, ubicado en el centro de la galaxia Messier 87, a 53.000.000 años luz de aquí). Crédito: Event Horizon Telescope, 12/05/2022.

Nuestra galaxia y su centro

La Vía Láctea, esa franja turneriana que, irreverente, taja el cielo nocturno, no se trata sino del Sol incansablemente repetido. En el detalle, su textura lechosa se disuelve en cientos de miles de millones de puntos; cada uno de esos puntos, una estrella; cada una de esas estrellas, un sol en la distancia. El número de estrellas en nuestra galaxia es enorme: unas 200.000.000.000 estrellas, se estima. Se trata de uno de esos números que, sin importar la notación que elijamos para escribirlo, se nos presenta intuitivamente inasequible. Quizá ayude pensar que, si en un acto de justicia poética, cumpliésemos con asignar una de esas estrellas a cada alma que alguna vez haya existido, aun así quedarían en la galaxia muchas estrellas sin alma. Todas esas estrellas giran en torno a un centro común en el que, como intuían Kant y otros, existe un enorme astro. Laplace entendió la razón por la que ese astro permanece invisible a nuestros ojos: “los cuerpos más grandes en el universo podrían ser invisibles debido a sus propias magnitudes”, sugirió. Su invisibilidad sería inmanente. Los astros de tales dimensiones, que hoy llamamos “agujeros negros”, generan un campo gravitatorio tan intenso que ni siquiera la luz puede salir de ellos. Es su propio peso el que los sume en la más absoluta invisibilidad. Absolutamente nada puede escapar de su interior; ninguna luz, materia o radiación puede dejarlos. Su interior se encuentra, así, causalmente desconectado de nosotros: nada de lo que ahí adentro ocurre puede ser causa de un efecto externo. De este modo, si definimos el espacio como el escenario en el que acaecen los fenómenos físicos, no es inexacto decir que el espacio se acaba allí, en la superficie de los agujeros negros, en el llamado “horizonte de eventos”: Los agujeros negros son un bocado arrancado al espacio. El espacio mismo se recorta respetando la forma cuasiesférica de esos astros terriblemente gravitantes. Para toda consciencia externa, el espacio acaba allí; los agujeros negros son la misma ausencia del espacio en el que existen.

Los agujeros negros y la teoría de la relatividad

Los agujeros negros son los astros más fascinantes del universo. Su física es desconcertante, en cuanto su existencia tiene algo de paradojal: Si bien se trata de objetos astrofísicos oscuros, fríos y silentes, terminan estando aparejados con los fenómenos más violentos, energéticos y luminosos del universo. Al mismo tiempo, los agujeros negros desafían nuestra intuición hasta llevarnos al asombro; todas las nociones básicas de la física, como espacio y tiempo, se distorsionan cerca de ellos.

Los agujeros negros son una predicción de la teoría general de la relatividad, formulada por Einstein hacia fines de 1915. Esta teoría es, sobre todo, una teoría sobre la interacción gravitatoria. Según Einstein, la interacción gravitatoria entre dos cuerpos (podemos pensar en el ejemplo de un astro orbitando a otro astro mayor) no se debe a que actúe entre ellos una fuerza en el sentido newtoniano sino a que cada uno de esos cuerpos, debido a su masa y su energía, curva el espacio en el que se encuentra, imprimiendo su huella en el entramado espaciotemporal. Según esta imagen einsteniana de la gravedad, la órbita de la Luna en torno a la Tierra no es debida a que exista entre ellas una fuerza, sino a que la masa de la Tierra curva el espacio-tiempo en su cercanía y, así, la Luna no hace sino ceñir su trayectoria a dicha curvatura. En la teoría de Einstein la gravedad ya no es una fuerza sino la curvatura del espacio mismo; la fuerza se ha transformado en geometría. Esto implica que también los rayos de luz verán desviadas sus trayectorias en las cercanías de un astro gravitante: en cuanto navegante del espacio, la luz no escapa del destino de amoldar su andar a las formas que otros cuerpos le imponen al espacio-tiempo. Esta deflexión de los rayos de luz debido a la cercanía de un astro gravitante es quizá una de las predicciones más sorprendentes de la teoría de Einstein. Ahora bien, la curvatura del espacio-tiempo tiene, por así decirlo, un límite: Si el astro es lo suficientemente denso, entonces el entramado espaciotemporal se curva tanto que forma un horizonte de eventos, i.e. una superficie que puede ser pensada como “un punto de no retorno” que divide el interior y el exterior del astro estableciendo una separación causal entre ambas regiones: nada del interior puede transmitir información al exterior ni afectarlo de manera alguna. Debemos este descubrimiento a Schwarzschild, quien, en la navidad de 1915, mientras se encontraba en el frente de batalla en la Primera Guerra, advirtió que la teoría de Einstein predecía que un objeto esférico que fuera lo suficientemente denso (e.g. que tuviera la masa del Sol concentrada en un volumen de 6 kilómetros de diámetro) acabaría formando un horizonte de eventos y convirtiéndose en un agujero negro.

Los agujeros negros como objetos astrofísicos

Durante mucho tiempo los agujeros negros fueron considerados una curiosidad matemática, una predicción de las ecuaciones de la teoría einsteniana de la gravitación pero que dudosamente existirían en la naturaleza. ¿Astros lo suficientemente densos como para que su propia gravedad impida que nada de lo que ocurre adentro de ellos pueda afectar al exterior? Al comienzo esto sonaba descabellado, incluso para los expertos en la teoría de la relatividad. El mismo Einstein dudó de la existencia de los agujeros negros como objetos físicos, y hacia fines de los años 30 publicó un artículo en el que sugería que éstos no podrían existir. Más tarde, entre fines de la década de 1930 y comienzos de la década de 1970, con el refinamiento progresivo de la física nuclear, de la física estadística, de la astrofísica y de la formulación matemática de la teoría de la relatividad, una serie de trabajos vendría a dejar en claro que los agujeros negros podrían ser mucho más que una mera idealización matemática de la teoría de Einstein. Los nombres de Chandrasekar, Lifshitz, Oppenheimer, Penrose, Snyder, Tolman, Volkoff son asociados a los distintos avances que, a lo largo de casi cuarenta años, nos permitieron entender la genealogía estelar y nos convencieron de que los agujeros negros pueden, en efecto, formarse tras el colapso gravitacional de estrellas suficientemente masivas. Al final de sus vidas, tras agotar el combustible nuclear que alimenta su luz, las estrellas con determinadas características colapsan sobre si mismas debido a su propia gravedad. Esto produce una explosión termonuclear. Si la estrella original tiene una cantidad suficiente de masa (aunque no demasiada) entonces el colapso gravitacional es imparable y termina convirtiéndose en un agujero negro.

La primera evidencia observacional de la existencia de los agujeros negros data de 1964. Dado que los agujeros negros son por definición invisibles, verlos comporta una dificultan inherente. Así, y como sugería tempranamente Michell, su existencia debe ser inferida a partir del comportamiento de la materia y la luz en sus inmediaciones: cerca de los agujeros negros la materia se arremolina, se calienta y se ioniza. Como resultado de esto, el astro oscuro se envuelve en un ambiente extremadamente luminoso, que emite en diferentes frecuencias; en particular, en rayos X. La primera fuente de rayos X identificada como un agujero negro fue Cygnus X-1, un sistema binario de nuestra galaxia que consiste en un agujero negro de más de 20 masas solares y una estrella azul supergigante. Descubierta casi de casualidad durante un vuelo en cohete, Cygnus X-1 fue durante mucho tiempo la evidencia más fuerte de la existencia de esos astros oscuros. Hoy, a 58 años de aquella observación, la evidencia de la existencia de los agujeros negros es abrumadora: fuentes de rayos X y gamma, detecciones de ondas gravitacionales, quásares, órbitas de estrellas en el centro galáctico, son sólo algunas de las pruebas de que los agujeros negros pueblan el cosmos.

En abril de 2019, la colaboración Event Horizon Telescope (EHT) dio a conocer la primera fotografía de un agujero negro. Se trata del agujero negro supermasivo M87*, de 6.600.000.000 masas solares, ubicado en el centro de la galaxia Messier 87 (M87), a 53.000.000 años luz de aquí. Un astro de esas dimensiones a tal distancia subtiende un ángulo de observación de algunas decenas de microsegundo de arco, lo que equivale al ángulo subtendido por una manzana en la superficie de la Luna vista desde el barrio de San Telmo. Un ángulo similar es el subtendido por el agujero negro supermasivo que se encuentra en el centro de nuestra galaxia, Sagittarius A*, que se encuentra miles de veces más cerca (26.000 años luz) pero es también miles de veces más pequeño (4.000.000 masas solares). A esto se debe que EHT haya elegido ambos targets de observación: M87* y Sagittarius A* (aunque la variabilidad mayor de la imagen de Sagittarius A* hace su observación más complicada que la de M87*). El día de hoy, 12 de mayo de 2022, EHT dio a conocer la fotografía de Sagittarius A*; pero hablaremos de esto más abajo.

Intuiciones

Si bien los agujeros negros son una predicción de la teoría general de la relatividad, hubo ya en el siglo XVIII quienes, con intuición genial, intuyeron que astros de tales características podrían existir: En 1784, Michell supuso que astros de la densidad del Sol pero de muchísimo más grandes que éste podrían poblar el cosmos. Calculó cuánto más grande debería ser un astro tal para que la luz no pudiera escapar a su propia gravitación, y obtuvo un valor enorme: Cerca de 500 veces más grande que el Sol, sus cálculos decían. El radio del Sol es aproximadamente 700.000 kilómetros, lo que para Michell implicaba que sus hipotéticas estrellas negras, en caso de existir, serían gigantescas: Diámetros de cientos de millones de kilómetros, estimaba. Hoy sabemos que, de hecho, agujeros negros de tales tamaños existen en el universo; e incluso los hay más grandes y más masivos; colosales astros oscuros que someten gravitatoriamente a su propia luz y ejercen su influencia gravitatoria también sobre los otros astros. Michell vio en esto una manera de observar el fenómeno; pensó en cómo el influjo de las estrellas negras sobre los otros astros nos permitiría saber de su existencia: Aunque oscuros, aunque invisibles, esos astros enormes generarían un campo gravitatorio que afectaría el movimiento orbital de los cuerpos celestes que estuvieran cerca de ellos, y si esos otros cuerpos sí fueran luminosos entonces podríamos inferir de su extraño comportamiento la presencia de la enorme estrella oscura:

[P]odríamos tener indicio [de su existencia] si se diera que algún otro cuerpo luminoso orbitara en torno a ellos, cuyos movimientos no pudiéramos explicar mediante otras hipótesis (Michell, 1784).Es precisamente este fenómeno lo que hoy vemos, por ejemplo, en nuestra galaxia: El agujero negro del centro de la Vía Láctea, el gigantesco Sagittarius A*, es invisible a los ojos, pero el comportamiento de las estrellas cercanas a él, sometidas a su gravedad, termina delatándolo.

En 1796, de manera independiente y simultánea a Michell, Laplace también imaginó la existencia de las estrellas negras. Lo reportó en las primeras ediciones de su Exposition du Système du Monde y en un trabajo posterior de 1799. A diferencia de Michell, Laplace consideraba en su Exposition la hipótesis de astros más densos, con densidades comparables a la de la Tierra. Fue así como los diámetros de las estrellas negras pensadas por Laplace eran la mitad de los estimados por Michell. Laplace escribía:

La atracción gravitatoria de una Estrella con un diámetro 250 veces más grande que el diámetro del Sol y de una densidad comparable a la de la Tierra sería tan grande que la luz no podría escapar de su superficie (Laplace, 1796).Sugirió incluso que, debido a esto, “[l]os cuerpos más grandes en el universo podrían, entonces, ser invisibles debido a sus propias magnitudes”; o, tal como el marqués lo expresara: “[I]l est donc possible que les plus grands corps lumineux de l'univers, soient par cela même, invisibles”.

La hipótesis de que los agujeros negros tuvieran la densidad de astros conocidos, como el Sol o la Tierra, era por supuesto piadosa para los astrónomos del siglo XVIII. El bestiario de objetos astronómicos es rico y variado, por lo que esa hipótesis no está justificada y, de hecho, resultó incorrecta. También era incorrecta la idea de que la luz emitida por uno de esos astros dejaría por un lapso breve la superficie antes de volver a caer sobre sí misma: los agujeros negros no emiten luz en absoluto. Aun así, la intuición de Michell y Laplace, tan osada cuanto oscura, fue genial. Hoy tenemos evidencia incontestable de que su predicción más importante era cierta: “Los cuerpos más grandes en el universo [son] invisibles”. En el centro de nuestra galaxia hay uno de ellos.

La existencia de un enorme astro en el centro de la Vía Láctea data también del siglo XVIII. En su libro de cosmología, aparecido de manera anónima en 1755, Kant escribió:

Si los centros de todos los grandes sistemas mundiales son cuerpos ardientes, con mayor razón se puede suponer lo mismo del cuerpo central de aquel inmenso sistema que forman las estrellas fijas. Pero este cuerpo cuya masa debe estar relacionada a la magnitud de su sistema, ¿no se destacaría ante los ojos, si fuera un cuerpo de luz propia o un sol, con extraordinario brillo y tamaño? Sin embargo, no vemos lucir en el ejército celeste ninguna estrella fija que se distinga especialmente (Kant, 1755).Acaso porque Kant identificó erróneamente ese astro central de la Vía Láctea con la estrella Sirio, propuso la siguiente explicación de su visibilidad: “[N]o debe extrañarnos que no sea así [que no destaque ante nuestros ojos]. Pues aun cuando superase 10.000 veces nuestro sol en magnitud y si se supiese su distancia 100 veces mayor que la de Sirio, no podría aparecer con mayor tamaño y brillo que este”. Sirio (Alpha Canis Majoris) es la estrella más brillante del cielo nocturno, y fue quizá por su luminosidad que Kant llegó a creer que Sirio se trataba de un sol enorme y distante que yacía en el centro de la Vía Láctea. Hoy sabemos que Sirio es, en realidad, un sistema estelar binario relativamente cercano: a unos 8,6 años luz de distancia de nuestro planeta, unas 3.200 veces más cerca que el centro galáctico.

La presencia de un astro en el centro de nuestra galaxia fue también anticipada de manera donosa por Edgar Allan Poe en su Mellonta Tauta, esa hermosa bitácora imaginada de un viaje galáctico en globo:

El movimiento evidente de nuestro sistema en los cielos fue (¡extraño decirlo!) referido a una órbita alrededor de una estrella prodigiosa en el centro de la galaxia. Acerca de esta estrella, o en todo caso acerca de un centro de gravedad común a todos los globos de la Vía Láctea (…) Este orbe central, sin embargo, dinámicamente, debería haber sido más grande que todos los orbes circundantes tomados en conjunto. Entonces, podría haberse hecho la pregunta: “¿Por qué no lo vemos?” (…) Pero incluso admitiendo que el orbe central no fuera luminoso, ¿cómo arreglárselas para explicar que no se hiciera visible por la incalculable hueste de gloriosos soles que deslumbraban en todas direcciones a su alrededor? (Poe, 1849).Estas intuiciones resultaron correctas: Los centros de todos los grandes sistemas contienen cuerpos con masas relacionadas a sus enormes magnitudes. Las galaxias con núcleos activos que iluminan el cielo son, como Kant aventuraba, “grandes sistemas mundiales con centros ardientes”, de masas comparables a las de miles de millones de soles. Esos centros ardientes, sin embargo, cobijan celosamente astros centrales que son, en esencia, invisibles.

Sagittarius A*

Hasta donde sabemos, todas las galaxias (al menos, las galaxias grandes) tienen en su centro un agujero negro supermasivo. E incluso sabemos que existían ya agujeros negros supermasivos en los centros galácticos cuando el universo era aún muy joven, cuando tenía el 5% de su edad actual (lo que nos deja como pregunta cómo pudieron formarse astros tan grandes en tan poco tiempo). En algunos casos, los agujeros negros alcanzan decenas de miles de millones de masas solares. Es el caso de TON 618, el agujero negro más grande conocido hasta la fecha, 16.500 veces más masivo que nuestro Sagittarius A*.

Sagittarius A* fue detectado primero como una fuente de radio. Se trata de una fuente compacta y brillante de radiación electromagnética en radiofrecuencia. Se ubica en la constelación de Sagitario, y a eso debe su nombre. Forma parte de una radio-estructura aún mayor, llamada Sagittarius A, descubierta por Jansky a comienzos de 1933. El asterisco en el nombre Sagittarius A* corresponde a que esa fuente específica del conjunto Sagittarius A parece “excitada”. Fueron Balick y Brown quienes detectaron Sagittarius A* por primera vez, en 1974. Pocas décadas después quedaba ya claro que Sagittarius A* era una fuente de características de emisión y compactibilidad compatibles con las de un agujero negro supermasivo. Más tarde, el monitoreo de las órbitas de estrellas en torno al centro galáctico permitió concluir que, en efecto, Sagittarius A* está asociada a un agujero negro de más de 4.000.000 de masas solares que se encuentra en el centro de nuestra galaxia, a unos 26.000 años luz de nuestro sistema solar. Las pacientes imágenes en infrarrojo muestran que, cada 15,56 años, la estrella S02 completa una órbita en torno al enigmático astro oscuro que es foco de una cuasi-elipse gigantesca y apreciablemente excéntrica. S02 recorre esa elipse cada década y media, y lo hace de una forma que sería sisífica si no fuera por un ligero corrimiento del perihelio que la teoría de la relatividad le cobra como peaje. Es también a la teoría de la relatividad que S02 debe sus sutiles cambios de color: En la parte de la órbita que más le permite acercarse al agujero negro, a una distancia de 17 horas luz, S02 alcanza velocidades de miles de kilómetros por segundo, algo así como 1/60 de la velocidad de la luz. Esto permite observar efectos relativistas, como el corrimiento al rojo de la luz de la estrella debido a la alta velocidad que ésta alcanza respecto a nosotros (fenómeno predicho por la teoría especial de la relatividad). También se observa un corrimiento al rojo debido al intenso campo gravitatorio en las cercanías del agujero negro (efecto predicho por la teoría general de la relatividad). El corrimiento del perihelio de S02, decíamos ya, también parece compatible con lo predicho por la teoría de Einstein. Como la de S02, las órbitas de otras estrellas también muestran movimientos que están de acuerdo con la ubicación y masa del agujero negro. El estudio de esas estrellas en torno a Sagittarius A* valió la mitad del premio Nobel en física de 2020, otorgada a Genzel y Ghez, un astrónomo y una astrónoma involucrados en dos de los equipos que observaron con ingenio y acribia las órbitas en torno al centro de la Vía Láctea. Hoy la radio-fuente Sagittarius A* le cede su nombre al agujero negro que allí se encuentra.

Event Horizon Telescope

Según la teoría de Einstein, un agujero negro de 4.000.000 de masas solares como el que se encuentra en el centro de nuestra galaxia tendría un diámetro de unos 24.000.000 kilómetros. Esto puede parecernos mucho, pero a escalas galácticas no lo es. De hecho, un tamaño de 24.000.000 kilómetros empalidece al lado de los 26.000 años luz (miles de billones de kilómetros) que nos separan del centro galáctico. Esto significa que un astro como el que se encuentra en el centro galáctico subtiende un ángulo muy pequeño visto desde nuestro planeta: se trata de un ángulo de unas decenas de microsegundo de arco. Esto comporta una seria dificultad a la hora de observarlo: Dijimos ya que sería equivalente a querer observar una manzana en la superficie de la Luna. Lograr una resolución semejante, teniendo en cuenta la frecuencia con la que se observa en este caso (en el espectro de radiofrecuencia, a 230 GHz), exigiría un radiotelescopio tan grande como nuestro planeta. Para sortear esta dificultad, la colaboración Event Horizon Telescope, que reúne a cientos de científicos bajo la dirección de Sheperd Doeleman, coordina una red global de radio-observatorios que trabajan de manera sincrónica para observar fuentes de radio asociadas con agujeros negros con una resolución angular comparable a la del horizonte de eventos de Sagittarius A*. Los telescopios que forman la red son muchos: el radiotelescopio del Gran Telescopio Milimétrico Alfonso Serrano, en México; los radiotelescopios del Atacama Large Millimeter Array y el Atacama Pathfinder Experiment, en Chile; el South Pole Telescope, en la Antártida; el James Clerk Maxwell Telescope y el Submillimeter Array, en Hawái; el Submillimeter Telescope, en Arizona; el radiotelescopio del Instituto Radioastronómico Milimétrico, en España. Desde el llano de Chajnantor en el desierto de Atacama hasta el monte Mauna Kea de Hawái; desde el polo sur hasta la loma de Dilar en Sierra Nevada. Todos esos telescopios coordinados forman una red global que convierte a nuestro planeta en un gran radiotelescopio virtual del tamaño necesario para observar a Sagittaruis A* con la resolución angular necesaria para ver su horizonte de eventos. El 12 de mayo de 2022, en conferencias de prensa simultáneas alrededor del globo, la colaboración Event Horizon Telescope presentó la imagen de la primera imagen de Sagittarius A* (y la segunda de un agujero negro). La imagen muestra la sombra del agujero negro en el centro de la Vía Láctea aparecer recortada sobre su fondo que lo envuelve.