Del Big Bang a Argentina: el universo temprano a través de ondas gravitacionales

- 2025-11-27 14:00 |

- Aula Federman

* Por Luciana Bruno

En la página web de la Agencia Nacional de Promoción Científica y Tecnológica, organismo que otorga y administra fondos destinados, entre otros, a la investigación científica y tecnológica en Argentina, se lee lo siguiente:

“La evaluación de proyectos se caracteriza por la transparencia en sus acciones y por su procedimiento ético. El mérito de los proyectos es el único criterio de recomendación utilizado para la adjudicación de los subsidios y se determina a partir del análisis de la calidad y la pertinencia de los mismos” [1].

¿Quién podría no estar de acuerdo con estos principios rectores? Sin embargo, ¿es posible garantizar o al menos acercarse al ideal de objetividad en un proceso de evaluación real? El artículo que recomiendo, aparecido en la versión digital de la revista Physics Today el 1 de marzo de 2019 narra una experiencia piloto en ese sentido [2].

El caso desarrollado trata sobre la evaluación por pares que realiza el Instituto de Ciencia del Telescopio Espacial (STScI) para la asignación de tiempo de uso del Telescopio Espacial Hubble. El proceso de selección es altamente competitivo: cada año sólo una quinta parte de las más de mil propuestas presentadas sobreviven al riguroso sistema de revisión. El procedimiento de evaluación de los proyectos es muy similar al utilizado,

por ejemplo, por agencia argentina para el otorgamiento de subsidios para la investigación tales como los Proyectos de Investigación Científica y Tecnológica. El STScl invita a unos 150 astrónomos de la comunidad internacional a revisar las aproximadamente 1100 a 1200 propuestas y hacer recomendaciones a la dirección del Instituto del telescopio espacial. En una primera ronda de clasificación, los pares revisores, trabajan de forma remota y asignan calificaciones a las distintas propuestas. Luego, el personal de Instituto genera una lista de los proyectos altamente calificados que son discutidos por paneles de ocho a diez miembros que se reúnen en persona y determinan las propuestas ganadoras.

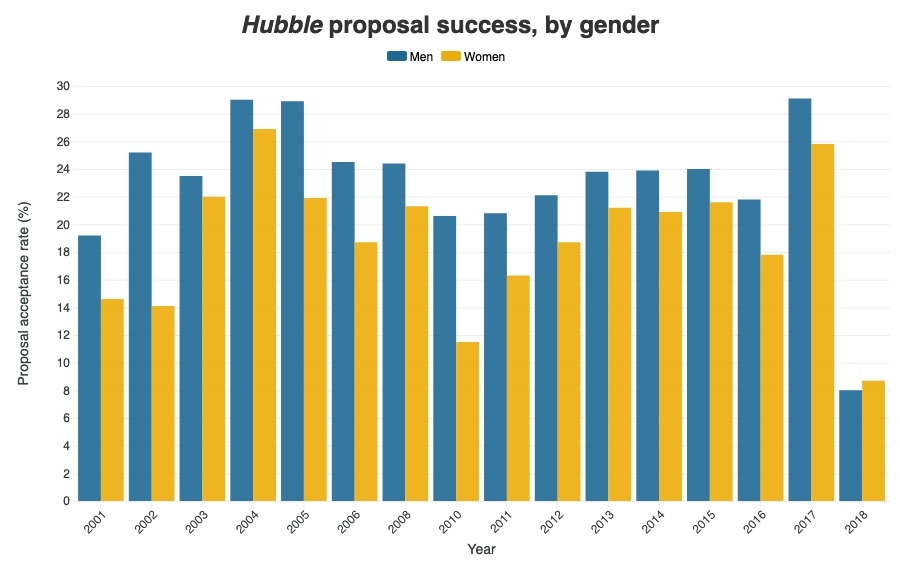

El artículo cuenta que Neill Reid, director asociado del STScI decidió examinar los resultados de las evaluaciones entre 2001 y 2012 y descubrió que las tasas de éxito de las propuestas lideradas por investigadoras mujeres -19%, en promedio- habían sido peores que las tasas de éxito de sus contrapartes masculinas -23%-. Aunque esta diferencia parecía menor, el desequilibrio fue sistemático, revelando un patrón de desventaja mediada por el género.

Frente a estos resultados, el Instituto de Ciencia del Telescopio Espacial decidió tomar cartas en el asunto y analizar el proceso de evaluación en detalle para dilucidar en qué momento del procedimiento se producía el sesgo (consciente o inconsciente) por género. Curiosamente, no se hallaron evidencias de desviación durante la calificación preliminar. Fue sólo en las reuniones de los paneles que el sesgo apareció y permitió identificar una razón potencial para ello: gran parte de la discusión sobre una propuesta dada se centraba en el historial del solicitante y sus colegas, en lugar de sobre la ciencia que él o ella estaba proponiendo.

Con estos resultados a la vista, se decidió hacer una prueba piloto que consistió en una evaluación doble-ciego en la última etapa de la selección: ni los evaluadores ni los evaluados sabían quién era la contraparte. Además, se incorporaron veedores en estas reuniones cuya función consistió en re-enfocar el debate de los evaluadores cuando la discusión se desviaba de la consideración del plan científico, como por ejemplo, intentar adivinar quién era el o la postulante.

Y los resultados fueron impresionantes: por primera vez, las propuestas lideradas por mujeres tuvieron una tasa de éxito mayor que las dirigidas por hombres. Los autores del trabajo sostienen que un proceso de revisión doble ciego tiene el potencial de nivelar el campo de juego, no sólo para las mujeres sino también para otros grupos marginados y desfavorecidos.

Sería interesante analizar si este tipo de sesgo ocurre en las distintas instancias de evaluación por las que transitamos durante nuestra carrera científica. Es por eso que les sugiero leer el artículo y pensar si podemos aprender algo de la experiencia del STScl.

*La autora es miembro de la Subcomisión de Género de la Asociación Física Argentina e Investigadora independiente CONICET, Instituto del Cálculo, Exactas, UBA.

1. https://www.argentina.gob.ar/ciencia/agencia/fondo-para-la-investigacion-cientifica-y-tecnologica-foncyt/evaluacion

2. https://physicstoday.scitation.org/do/10.1063/PT.6.3.20190301a/full/